企業導入 AI 為何須重新思考資安?「5 大情境」解析最常忽略的風險

當企業將 AI 用於提升效率、降低成本,資安卻常被忽視。世界經濟論壇最新報告《2025 年全球網路安全展望》,揭示了一項令產業不安的數據──多數(66%)受訪組織認為 AI 將在未來一年內衝擊網路安全,卻只有少數(37%)組織表示已制定安全部署 AI 工具的流程,這種落差被稱為「AI 與資安困境(AI–cyber paradox)」,已成為企業不得不面對的新挑戰。

事實上,AI 大型語言模型(LLM)不只是工具,也是全新的攻擊面。根據世界經濟論壇,在 AI 採用和部署流程中,如果沒有充分考慮資安風險和因應措施,可能不知不覺在 IT 基礎設施引入漏洞。那麼,究竟什麼樣的情境,可能讓 AI 變得不安全?

情境 1:閉源、開源 AI 和第三方組件本身就有資安風險

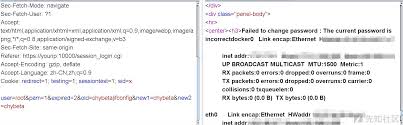

企業在導入 AI 過程中,可能使用多種閉源和開源 AI 模型,然而市面上不同模型的品質和安全態勢可能存在巨大差異。軟體供應鏈公司 JFrog 觀察,2024 年,全球最大公開機器學習模型平台 Hugging Face 上新增的模型與資料集超過 100 萬個,與此同時,惡意模型的數量也成長了 6.5 倍。也就是說,AI 模型成為駭客釣魚攻擊的工具,增加企業選用 AI 模型的安全風險。

思科在《2025 AI 資安現況》指出,AI 生態系仰賴共享的模型、資料集與函式庫,這使得攻擊面擴大至整個 AI 供應鏈。無論是預訓練模型、開源函式庫,或是用於訓練 AI 系統的資料集,AI 供應鏈攻擊利用了企業對第三方工具的信任──當某環節遭入侵,問題往往在造成重大損害之後才會被發現,並可能對多個下游應用與系統造成影響。

情境 2:針對 LLM 微調?產生有害輸出可能性高出 22 倍

根據致力於 Web 應用程式安全性的國際非營利組織 OWASP 發布的 LLM 十大風險清單,駭客可以進行資料與模型投毒(Data and Model Poisoning),針對 LLM 生命週期的不同階段進行操弄,例如預訓練、微調和嵌入。

其中,「微調(Fine-tuning)」階段特別值得關注。思科研究發現,經微調的 LLM 產出有害內容的可能性是基礎模型的 22 倍。根據 OWASO,有害內容指的是 LLM 產生不安全、不當、具有潛在威脅或負面影響的輸出,例如違反安全規範、被惡意利用的程式碼、釣魚或詐騙、誤導性內容、敏感資訊洩露等。

雖然微調有助於提升模型在特定情境下的準確性,但也會削弱 AI 模型原有的安全機制,暴露在越獄、提示注入等攻擊手法之下。思科研究測試多個經過微調、被應用於醫療、金融與法律領域的模型,包括 Llama-2-7B 等,指出服務特定專業應用導向的微調模型,也難以擺脫被攻擊的風險。

情境 3:當企業吹起 Vibe coding 風潮,敏感資料面臨外洩風險

生成式 AI 對軟體工作流程帶來重大變化,開發人員越來越依賴 AI 寫程式工具如 GitHub Copilot、Cursor 來輔助軟體開發,這也讓「Vibe coding」成為矽谷最新流行語──這是一種新的程式撰寫狀態,意指透過幾個提示詞,不需要親手撰寫程式碼,就能做出整個應用程式。

然而,資安平台 GitGuardian 調查,在啟用 AI 寫程式工具的程式庫中,敏感資訊洩漏的比例比一般公開程式庫高出 40%。GitGuardian 執行長 Eric Fourrier 指出,AI 雖然加速開發流程,也讓安全風險升高,特別是非人類身分(如機器帳號、API 金鑰)相關的漏洞。

Fourrier 表示,有經驗的開發者可能會立刻察覺 AI 生成程式碼涉及的風險並進行修改,但對於資歷較淺或有時間壓力的開發者來說,可能會直接複製貼上 AI 生成結果。然而,一旦敏感資訊被提交至程式庫,就可能被惡意人士擷取利用。

情境 4:AI 代理時代來臨,留意「過度代理授權」

OWASP 也揭露 AI「過度代理授權(Excessive Agency)」的資安風險。這項風險指的是,AI 模型被賦予超出預期操作所需的功能、權限或自主性,如果沒有積極控管,可能在模型幻覺、不良提示工程、直接或間接惡意提示注入等原因而產生錯誤輸出的情況下,仍然觸發具有損害性的行為。

造成過度代理問題的根本原因是,AI 模型可能經常需要與其他系統和服務互動以完成任務。OWASP 指出,考量到 AI 代理(Agentic AI)技術日益普及,目前至少已識別出 14 種不同的代理式系統威脅向量,強調未經檢查的權限可能導致意外或危險的行為。

情境 5:員工愛用但企業完全不知情的「影子 AI」

對企業來說,員工用 AI 提升工作效率是好事,但如果用的是「影子 AI」,可能危害自家資訊安全。科技媒體《VentureBeat》指出,「影子 AI」是未經授權、缺乏資安防護與治理規範的 AI 工具與應用,可能用於內部產出報表、行銷自動化、視覺化處理,甚至是進階數據分析,而且時常以企業內部資料為基礎,形成資料外洩風險。

根據 SoftwareAG 今年調查 6 千名知識工作者,有 50% 受訪工作者都在用「影子 AI」。然而,多數員工並非沒有風險意識,但使用的主要原因,53% 是基於自主性,另有 33% 表示企業尚未提供符合需求的工具。這顯示,企業如果希望員工使用經內部授權的 AI 工具,就必須重新檢視採用流程,確保能真正符合實際工作需求。

無論是選擇、部署或授權 AI 模型,以及管理員工自發使用的影子 AI,每個決策都可能成為資安破口。然而,當企業導入 AI 成為趨勢,「如何安全導入」將是企業在 AI 開發生命週期初始就須重新思考、評估的關鍵議題。