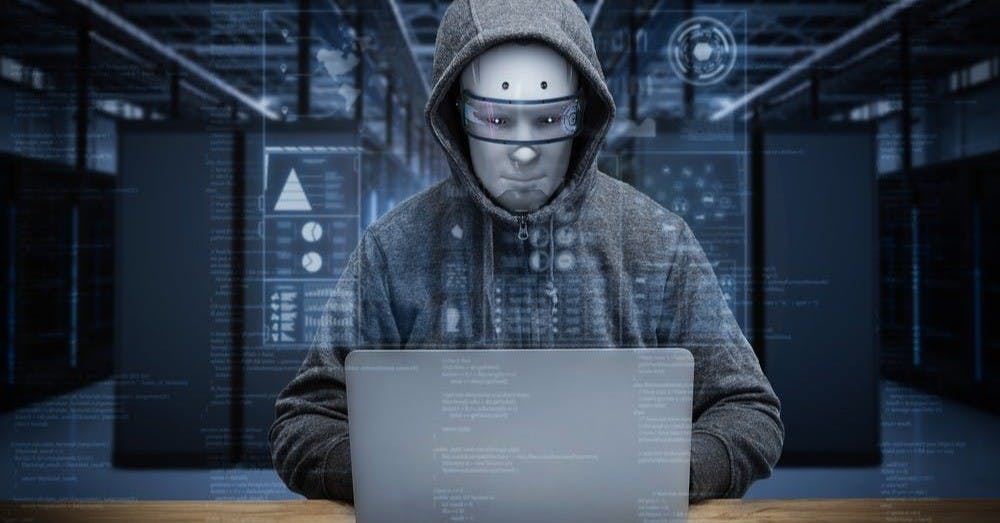

GPT-4 當白帽駭客!成功利用實驗中 87% 資安漏洞,成本便宜人工近 3 倍

GPT-4 當白帽駭客!成功利用實驗中 87% 資安漏洞,成本便宜人工近 3 倍

研究團隊透過 1-day 漏洞來測試 LLM 代理人(agent),代理人由四個元件組成:指令、基礎 LLM、ReAct 框架(在 LangChain 中運用),以及 terminal 和 code interpreter 等工具。

在提供 CVE 資料庫中對資安漏洞的描述後, GPT-4 成功利用 87% 的漏洞,反觀其他模型,包括 GPT-3.5、Llama-2 70B,以及專用的漏洞掃描程式,皆完全無法成功利用漏洞。

其中有 11 個測試的漏洞是在 GPT-4 訓練完後才發生,代表模型未能在訓練期間了解關於漏洞的任何資料,在這些測試中 GPT-4 的成功率略低,為 82%。

GPT-4 目前只能攻擊已知的漏洞,在沒有先提供 CVE 描述下,模型識別和利用漏洞的成功率只有 7% 。不過 GPT-4 的能力仍值得關注,因為模型不僅能從理論上理解漏洞,還可以自動化實際去利用漏洞。

研究員表示「現階段(LLM)無法解鎖人類專家做不到的新能力」,但他認為「組織透過最佳資安應用來避免被駭客攻擊是非常重要的,因這些 AI 代理人會開始被惡意運用。」

論文也計算出 LLM 代理攻擊漏洞的成本,每次攻擊成本為 8.8 美元,這比僱用一名專家 30 分鐘的成本便宜 2.8 倍」。 研究員預測,未來的 LLM(例如 GPT-5)資安能力只會變更強。

OpenAI 特別要求論文作者不要公開實驗中使用的指令,作者同意並表示只會「根據要求」來提供指令。